MBA. Hellen Ruiz Hidalgo

Comunicadora Estratégica

Observatorio de Comercio Exterior (OCEX)

Vicerrectoría de Investigación - Universidad Estatal a Distancia (UNED)

Introducción. El comercio ha sido, desde siempre, la forma fundamental de relación entre los pueblos. Su funcionamiento ha estado vinculado a las transformaciones productivas, logística de transporte y comunicación. En esas tres esferas, cada revolución se ha traducido en correspondientes cambios de la operatividad comercial. La introducción del instrumento computacional ha ido progresivamente revolucionando la vida social, política, económica, educativa y productiva. Su impacto en el comercio ha sido, consiguientemente, formidable, hasta en la cohesión social, en el propio relacionamiento humano, así como en las comunicaciones interpersonales y las internacionales. De ahí la importancia de hacer una retrospectiva de la evolución de la ciencia, técnica y práctica computacional desde sus inicios hasta nuestros días, subrayando en cada paso sus impactos en el comercio.

Dividiremos nuestro recorrido en cuatro cápsulas:

- En esta primera cápsula, haremos un recorrido histórico de los procesos tecnológicos de la computación, hasta llegar a los inicios de los grandes cambios a los que apunta la Inteligencia Artificial.

- Una segunda, se concentrará en los impactos directos e indirectos de la computación en el comercio internacional.

- En una cápsula posterior abordaremos el “Estado de Situación” de la Inteligencia Artificial en nuestros días.

- La geopolítica de la computación y la inteligencia artificial las abordaremos en una cápsula final de esta serie, donde nos concentraremos en la carrera de Estados Unidos y China por el predominio de la Inteligencia Artificial.

Impactos generales de la computación en la vida moderna y el comercio. Sin intentar ser de ninguna manera exhaustivos, haremos un pequeño recorrido en varios campos de actividad que serían impensables sin la presencia de la computación o cuyos alcances han sido revolucionados por ella.

- Comencemos por las actividades administrativas, más básicas, donde procesadores de palabras, hojas de cálculo y plantillas de presentación han facilitado y revolucionado las labores de oficina, pero también académicas y educativas y sería impensable la ejecución de esas actividades sin estas herramientas.

- En el campo de la salud, el empleo computacional en instrumentos electrónicos, con la aplicación del manejo de macro-datos y los avances de la robótica, a ella asociada, llegan aplicaciones que permiten desde la detección temprana de enfermedades cutáneas, hasta la “Tomografía Axial Computarizada”, decisivo medio de diagnóstico. También análisis de laboratorio y hasta ejecución de labores quirúrgicas por “autómatas quirúrgicos” a distancia, como “Da Vinci”, permite incluso cirugías cardíacas con mayor precisión y habilidad que la de un ser humano, ofreciendo, además, una visión tridimensional.

- En la sociología y la creación de sistemas de relacionamiento humano, se ha llegado a niveles demográficamente universales de participación en redes sociales interactivas. La misma política ha visto el uso de redes y de sistemas de comunicación computacionales jugando un rol importante en la manipulación de decisiones electorales. Caso relevante, en esto, fue el programa “Cambridge Analitica” que utilizó el conocimiento de las preferencias de uso de internet y de redes sociales, para dirigir de forma precisa la atención de los votantes hacia burbujas de comunidades afines, con objetivos electorales. Se dice que fue un instrumento decisivo en la primera victoria de Donald Trump, en 2016.

- En el mercadeo político electoral de la actualidad es universal el empleo de los instrumentos facilitados por la computación.

- En el campo de la publicidad y el manejo de las preferencias del consumidor la computación y sus aplicaciones son instrumentos usuales para segmentar mercados o focalizar las propuestas de productos.

- En la manufactura, la computación se ha introducido no sólo en procesos productivos automatizados sino también en los componentes de los mismos artículos elaborados. Así, por ejemplo, la crisis de distribución de “chips” por la paralización del transporte durante la epidemia del Covid-19, paralizó muchas industrias. Automóviles, lavadoras, refrigeradores, etc., elaboradas en procesos automatizados por computación, deben a la introducción de chips en sus mecanismos, los avances de sus funcionamientos.

- La comunicación interpersonal, por teléfonos inteligentes, ha sido llevada a escalas imposibles de imaginar, hace apenas unos años, en costos y distancias.

- En el tema del almacenamiento y manejo de archivos, la posibilidad de guardar documentos de forma digital en lejanos y masivos servidores de computación, ha creado el concepto innovativo de la “nube”, espacio cibernético de almacenamiento personal y empresarial.

- En el acceso inmediato y generalizado, no podemos dejar de mencionar los buscadores de internet, que ponen al servicio la acumulación universal de contenidos universales de la cultura humana, histórica, literaria, musical y visual.

El caso de la enciclopedia universal de Wikipedia. El concepto que resume toda esta transformación es el de “sociedad digital”, pero también el de “sociedad del conocimiento”. Mucho ha contribuido a esa denominación, un instrumento tal como Wikipedia. Esta es una enciclopedia realizada de forma colaborativa por decenas de miles de usuarios y alimentada con todo tipo de material susceptible de despertar algún interés. Wikipedia ha sustituido y posiblemente mejorado los esfuerzos intelectuales de pensadores y académicos profesionales.

Vale la pena mencionar brevemente sus antecedentes analógicos. En 1751, durante La Ilustración francesa, bajo el liderazgo de Denis Diderot y Jean le Rond d'Alembert, más de 200 científicos, literatos, filósofos y catedráticos universitarios del más alto nivel se pusieron de acuerdo, para redactar y publicar, 21 años después, en 1772, “La Enciclopedia o Diccionario razonado de las ciencias, las artes y los oficios”.

Desde entonces casi todos los países desarrollados han imitado ese esfuerzo. Se ha ido mejorando y actualizando, hasta su más famosa expresión en la Enciclopedia Británica, actualizada anualmente y en la que colaboraron personalidades tales como Marie Curie, Albert Einstein y Henry Ford. Pero suspendió su edición impresa, en 2012, ante la competencia de Wikipedia. Aun así, mantiene una edición digital.

Se valora que Wikipedia ha superado todas las enciclopedias impresas, tanto en número de artículos como en calidad científica. Produce 500 nuevos artículos al día, hasta llegar, actualmente a más de 5 millones. Realiza 21 ediciones y actualizaciones por minuto.

Vinculación de la computación con la industria y el comercio. En cada industria se han desarrollado aplicaciones de computación y las mismas aplicaciones de la computación han generado industrias propias. Ellas han creado necesidades nuevas que han resultado en nuevas demandas de las que han surgido continuos nichos especializados de mercado. Pero la propia computación también ha revolucionado las fuerzas productivas, aumentando la competitividad y generando nuevas formas de ventajas comparativas. A su vez, el mismo comercio internacional, tanto mayorista como al detalle, ha necesitado desarrollar sus propias aplicaciones propiamente, revolucionando la relación entre los diferentes países, así como entre productor, distribuidor y consumidor.

De esta introducción se deduce la importancia de conocer los antecedentes y desenvolvimiento de la computación hasta nuestros días. Su trayectoria, sus componentes y su acelerada introducción en los procesos productivos y en la misma la vida humana no son del dominio público. Se conocen sus impactos y se hace uso de sus productos sin cuestionar su origen. La computación se ha convertido en un supuesto interiorizado de la vida social, que ha arrebatado a la humanidad hasta su capacidad de asombro. Por eso hemos creído pertinente dedicar esta cápsula al tema de su nacimiento, evolución y de sus impactos, en particular en el comercio.

Las premisas productivas y comerciales que antecedieron a la computación. Pasa mucho tiempo entre la introducción de nuevos sistemas tecnológicos y su pleno empleo productivo. Así, por ejemplo, a comienzos del siglo XVII, se produjeron los primeros empleos productivos de la máquina de vapor. Se usó para bombear agua y tener más rápido acceso al material de las minas de carbón. Pero su plena aplicación industrial va a tardar más de un siglo para tener un empleo generalizado en los países europeos. Ahí marcó un punto de inflexión en la historia económica y comercial, modificando e influenciando todos los aspectos de la vida social y política, en lo que se llamó la “Primera Revolución Industrial”.

La producción industrial y agrícola se multiplicó y del nuevo desarrollo industrial nacieron nuevas clases sociales, como el proletariado y la burguesía. Las nuevas divisiones sociales surgidas dieron origen a la transformación política del antiguo régimen feudal, y después de grandes revoluciones políticas, nació la democracia liberal. Y a las transformaciones sociales y económicas nacionales correspondió, a su vez, revoluciones comerciales. El comercio dominado por las potencias industriales determinó la división del mundo en países industrializados y países dependientes. Nació el colonialismo extractor de materias primas que alimentarán las maquinarias industriales de las metrópolis coloniales. En ocasiones surgieron guerras comerciales propiamente dichas: lo que fue llamado el “comercio de las cañoneras”, donde la fuerza militar obligaba a países que se abrieran a un comercio desigual. Son los tiempos que antecedieron a la introducción de la computación en el universo productivo y social.

Los preludios de la computación y sus primeros pasos. Pasó mucho tiempo, prácticamente 200 años, antes que surgiera la introducción industrial de nuevos factores tecnológicos, productivos y sociales que revolucionarían todos los sistemas de organización y de producción. El punto culminante de la nueva transformación es el desarrollo y aplicación generalizada de sistemas de computación que, en su etapa superior, se ha llamado Inteligencia Artificial.

En 1936, Claude Shannon publicó la tesis doctoral que significó la base matemática para los desarrollos de la programación. En ella, Shannon relacionaba la lógica matemática de Boole con la posibilidad de generar instrucciones a circuitos eléctricos. El sistema de Boole se basaba en operaciones binarias de verdadero-falso, que se podía vincular a un interruptor eléctrico, conectado-desconectado. Esa fue la base matemática y tecnológica que va a permitir la computación relacionando un sistema binario (programación, software) con un circuito eléctrico (procesador, hardware).

Esta concepción genial, que conecta una instrucción matemática con un circuito eléctrico, donde un interruptor representa los dos estados del sistema binario, demostró que se puede utilizar la lógica de Boole para que una máquina efectúe operaciones lógicas y algebraicas complejas. Esa relación entre programación digital o binaria, con circuitos eléctricos fue la base de la computación. De ahí la palabra “digital”, es decir, binaria.

En su inicio se trataba solamente de diseñar instrucciones simples para realizar cálculos o ejecutar comandos en dispositivos electromecánicos. Pero, aunque de forma elemental, era ya una forma de reproducir en una máquina procesos que realizaba la mente humana para ejecutar una tarea. De ahí que desde sus inicios se introdujo a esa labor el concepto de “inteligencia”.

De esa manera, la primera historia moderna de la computación nació de la necesidad de elaborar métodos estadísticos para resolver problemas, tales como el almacenamiento y recuperación de datos estadísticos de población. Pero aún no se había vinculado la lógica matemática binaria del sistema de Boole con la mecánica simple de los circuitos eléctricos. Eso imposibilitó su implementación, pero dejó planteado el problema, es decir la mitad de su solución.

Guerra, comercio marítimo y computación. Es interesante la vinculación del desarrollo de la computación con el transporte marítimo de mercancías. La II Guerra Mundial creo las condiciones políticas para que el Estado financiara la inversión necesaria para la construcción de aparatos electromecánicos que permitieran la descodificación de mensajes encriptados.

Inglaterra recibía, por vía marina, apoyo comercial y militar que le brindaba Estados Unidos con grandes buques comerciales que viajaban en convoys a través del Atlántico. Con su flota de submarinos, Alemania los atacaba y hundía. Los convoys eran detectados desde el aire y transmitida su posición a Berlín que la remitía en mensajes codificados a sus submarinos. Todo en mensajes encriptados. Para que la ayuda llegara a Inglaterra, se necesitaba “descifrar” la encriptación de los mensajes militares alemanes.

El mercado privado, por sí mismo, jamás habría hecho semejante inversión porque pasarían muchísimos años antes que la computación rindiera retornos susceptibles de recuperar grandes inversiones. Ese es el tipo de erogación que sólo el Estado está en capacidad de hacer en situaciones de emergencia.

En 1936, tres años antes del estallido del conflicto mundial, el genio matemático Alan Turing trabajaba para la Escuela Gubernamental de Codificación y Descifrado del Servicio de Inteligencia Británico (Government Code & Cypher School, GC&CS). Turing conocía los trabajos de Shannon. En la mansión de Bletchley Park, de la colaboración de Turing, y Gordon Welchman, con los mejores ingenieros eléctricos ingleses, surgió un sistema (software) para que una máquina electromecánica de 1800 tubos eléctricos de vacío (semiconductores), llamada “La Bomba”, pudiera descifrar los mensajes entre Berlín y los submarinos alemanes, que utilizaban una compleja máquina de descifrado llamada “Enigma”.

Las primeras computadoras y sus limitaciones. En 1943, todavía durante la guerra y sobre esa base, apareció la primera computadora programable moderna, llamada ENIAC (Electronic Numerical Integrator And Computer). Era un aparato tecnológico enorme de 30 toneladas, con 18 mil tubos al vacío que ocupaban 170m2.

En 1945, el matemático John Von Neumann sintetizó las bases de funcionamiento de la computación en tres principios básicos:

- tener una memoria que integre instrucciones y datos,

- tener una unidad interna fija de cálculo de operaciones lógicas y

- controlar el manejo de datos para decidir acciones a partir de las instrucciones recibidas y de los resultados de las operaciones previas.

Con eso, la computación podía desarrollarse. Nada extraño fue que, después de la guerra, y en paralelo con el desarrollo lógico, matemático y tecnológico de la computación, comenzara a discutirse sobre la posibilidad de construir “máquinas” con la capacidad de imitar procesos mentales humanos.

Los circuitos eléctricos en los que se basaban las primeras computadoras, estaban compuestas por tubos de vidrio al vacío, frágiles y de precaria vida operativa de 48 horas. Eso significó el primer obstáculo: costos impagables y enorme empleo de energía. A eso se sumaba, desde el punto de vista comercial la ausencia del estímulo de demanda de mercado ya que sus aplicaciones iniciales eran limitadas y sus costos prohibitivos.

En 1947, ese obstáculo fue apenas parcialmente superado, cuando los tubos de vidrio al vacío se sustituyeron con transistores metálicos, mucho más pequeños que los tubos, de mayor duración y menor consumo de energía. Más tarde los transistores se aplanaron y, para producirlos, se imprimieron. Luego se diseñaron circuitos impresos en los que se insertaban.

Las computadoras personales y su impacto en el comercio internacional. Con los transistores quedaron fundadas las primeras bases de los elementos técnicos funcionales para producir máquinas que podían ser “instruidas” (programación) a realizar procesos simples semejantes a los procesos mentales humanos.

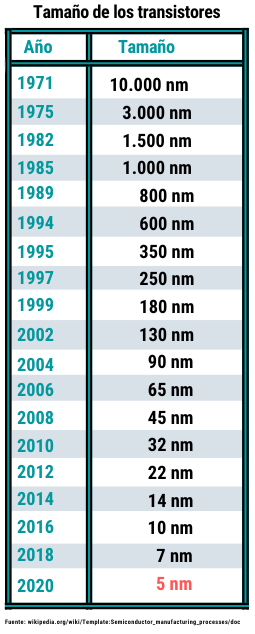

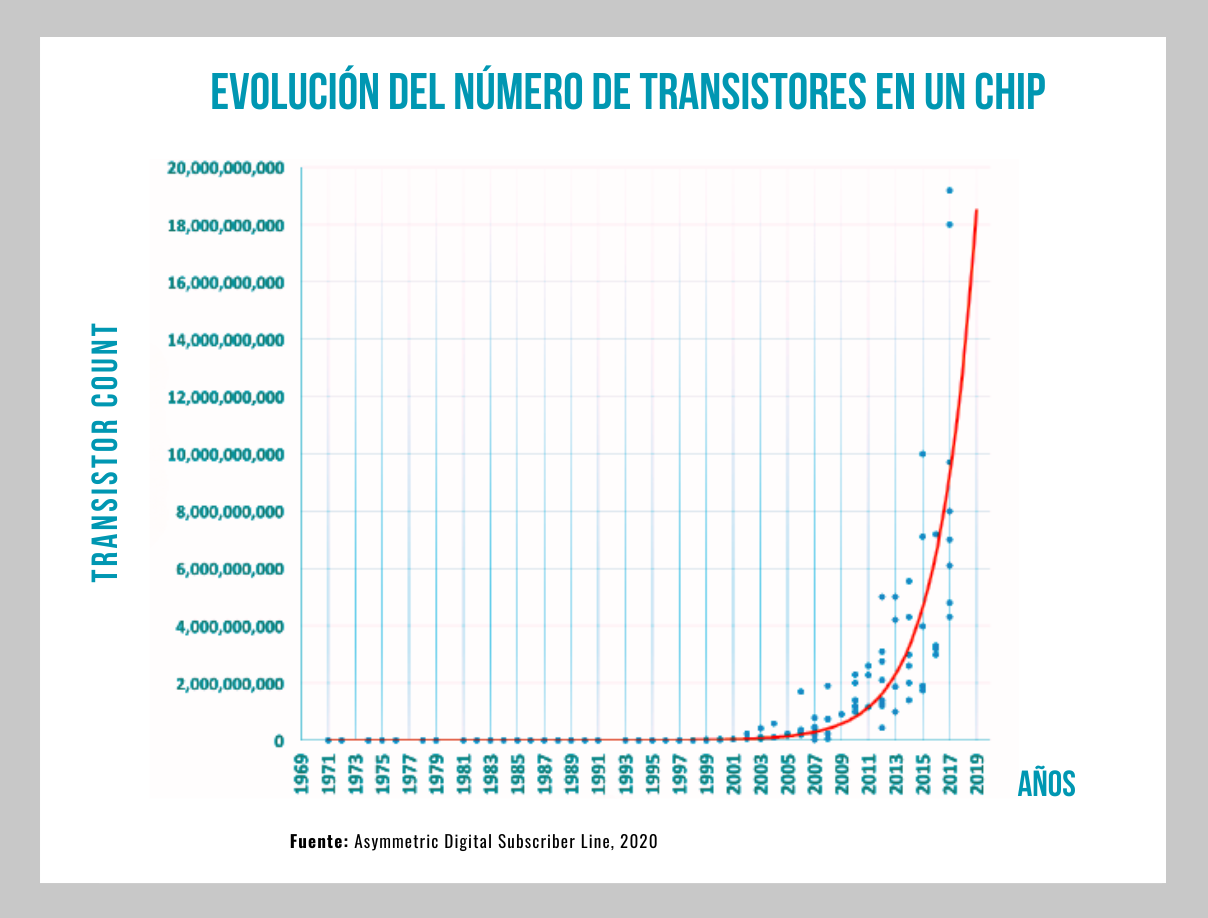

Aun así, la potencia computacional tenía como limitante el tamaño de los transistores. Esto fue superado porque fue cada vez más posible la disminución del tamaño de los transistores. Al ser cada vez más pequeños, los Circuitos Integrados (Chips) podían contener un número mayor de ellos. A su vez, al aumentar el número de transistores dentro de un chip, las computadoras eran capaces de realizar más operaciones por segundo.

Es la evolución de los chips que determinará la disminución de costos y de dimensiones de las computadoras. Eso les permitirá ser accesibles al público y a las empresas en general, lo que creará un nuevo mercado internacional, por el que competirán los países más desarrollados y un mercado de consumo cada vez más universal.

La ley de Moore. Esto ha sido asombroso y ha seguido, hasta ahora, las predicciones deductivo-intuitivas de la famosa y conocida Ley de Moore. En 1965, Gordon Moore, director entonces de investigación y desarrollo de Fairchild Semiconductor, escribió un artículo en la revista Electronics. Su título era: "Cramming more components onto integrated circuits" (Atiborrar más componentes en los circuitos integrados). En ese artículo, mostró que, desde 1959 hasta entonces, cada año se había duplicado la cantidad de transistores (componentes) que cabrían en un Circuito Integrado, es decir, en los Chips. Predijo que esta tendencia continuaría durante al menos otros 10 años.

Esto, obviamente, forma una progresión geométrica que rápidamente alcanza cifras enormes y, desde el punto de vista físico, no puede llegar al infinito. Obviamente, lo que decía Moore era una simple suposición, a partir de su observación. No se basaba en ninguna premisa tecnológica. Era simplemente lo que había ocurrido en apenas los últimos 5 años. No existía ninguna base para pensar que seguiría siendo así. Pero su intuición se reveló correcta. Por eso, a esa progresión del creciente número de transistores susceptibles de calzar en un Chip, se le denomina “Ley de Moore”. Se piensa que, sin embargo, esta Ley está llegando, a sus límites físicos, por lo menos con las tecnologías actuales. Pero hasta ahora se ha cumplido.

Evolución del número de transistores en un Chip y su impacto comercial. El resultado ha sido la disminución sistemática del tamaño de los transistores, lo que ha permitido que más transistores “alcancen” en un mismo Chip, cuya arquitectura computacional también ha evolucionado. Los datos son simplemente asombrosos.

![]() El primer Chip, al que se le comenzó a llamar microprocesador (transistor medido en micras), lo produjo Intel Corporation, en 1971. Intel había sido fundada apenas unos años antes por el mismo Moore, que comprendió las potencialidades de mercado que tenía su ley, por el abaratamiento de costos que significaría la construcción de computadoras.

El primer Chip, al que se le comenzó a llamar microprocesador (transistor medido en micras), lo produjo Intel Corporation, en 1971. Intel había sido fundada apenas unos años antes por el mismo Moore, que comprendió las potencialidades de mercado que tenía su ley, por el abaratamiento de costos que significaría la construcción de computadoras.

Ese avance sentó las bases tecnológicas para la distribución masiva de computadoras y la creación de un nuevo nicho de mercado. Le seguirían las programaciones correspondientes que crearían nuevas necesidades para un incremento de marcas, industrias, aplicaciones y empleos.

Desde la década de los 70 del siglo pasado comenzaron a desarrollarse computadoras de relativo costo medio, destinadas a usuarios individuales, como el Altair 8800 y el Kenbak-1. Pero fue hasta que Apple comercializó, en 1977, una computadora personal que se marcó verdaderamente el inicio de la popularización de las computadoras de fácil uso y accesible para el público general. Fue la Apple II. Pero su modelo basado en código cerrado impidió que, sobre su base, se desarrollaran softwares masivos aplicados a diferentes tareas, lo que disminuyó la velocidad de su difusión. Eso comenzó a ser superado en 1981, cuando IBM lanzó un modelo que terminó convirtiéndose en el estándar de facto para las computadoras personales, con sistemas operativos, como el MS-DOS y Windows, con código abierto, que marcaron un cambio significativo en la industria, ya que facilitaban programación libre para diferentes tareas, muchas vinculadas con la producción. A partir de ahí se creó un inmenso mercado y se generó la adopción masiva de las computadoras personales, comerciales, industriales, etc.

El proceso siguió. Chips con cada vez más transistores potenciaban la velocidad de procesamiento de datos y permitían aplicaciones cada vez más sofisticadas. No vamos a dar un seguimiento detallado a ese proceso, pero sí podemos saltar al presente para comparar el camino recorrido.

Comparación de los avances del número de transistores de los primeros Chips con los actuales. El primer Chip de Intel contenía 2300 transistores, podía realizar 60 mil operaciones por segundo, a una velocidad de 700 kHz. Actualmente, la computadora, Mac Pro de Apple, tiene el procesador (Chip) M1 Ultra, con 114 mil millones de transistores. Tiene una rapidez de procesamiento de 22 billones de operaciones por segundo, a una velocidad de 3.2Ghz. Los transistores del M1 Ultra miden 5 nanómetros. El M1 Ultra es producido por TSMC (Taiwan Semiconductor Manufacturing Company), la empresa líder de la producción miniaturizada de transistores.

Al apreciar esa comparación debe tenerse en cuenta que hemos comparado el primer chip de Intel con uno de los últimos de TSMC. Pero se trata de pequeñas computadoras personales. Las supercomputadoras tienen, en cambio, 20 veces más transistores. Una supercomputadora actual funciona con chips, como el Wafer Scale Engine (WSE), que integra nada menos que 1,2 billones de transistores, de transistores de 2 nanómetros.

Ese número de transistores logran calzar en un chip, porque han sido cada vez más pequeños. Increíblemente más pequeños. Los transistores de 1971 medían 10 micrómetros, (un micrómetro es la millonésima parte de un metro y diez micrómetros equivalen al diámetro promedio de un cabello humano). Los transistores actuales más pequeños miden 2 nanómetros (un nanómetro es la milésima parte de un micrómetro), es decir, son más 5 mil veces más pequeños que los transistores de 1971.

Si comparamos eso con el grosor de un cabello humano, podemos decir que el diámetro de un cabello se encuentra entre 80,000 y 100,000 nanómetros. La construcción de un material tan pequeño hace que sus procesos sólo puedan ser realizados, a su vez, por maquinaria especializada construida y dirigida por los propios programas de máquina-programación.

Cabe notar que semejantes proezas tecnológicas, con las técnicas actuales, tocan los límites de lo posible. Han sido fabricados solamente por un solo conglomerado de dos grandes empresas: la holandesa ASML (Advanced Semiconductor Materials Lithography)Advanced Semiconductor Materials LithographyASML (Advanced Semiconductor Materials Lithography), proveedor dominante de sistemas de litografía de circuitos integrados y la taiwanesa TSMC (Taiwan Semiconductor Manufacturing Company).

Vale decir también que el encadenamiento de sus producciones de Chips abastece la manufactura de todas las grandes compañías de computadoras, pequeñas o grandes, como Apple, Nvidia, Qualcom, AMD, etc. Es así como se produce un contraste entre el alto grado de concentración de las empresas de alta tecnología de computación y la generalizada y gigantesca cadena de valor expansiva, en el comercio internacional que ha tenido como resultante la universalización del empleo de la computación en todos los órdenes de la vida productiva, social y comercial.

La computación ha tenido un impacto profundo y transformador en el comercio internacional. La adopción de tecnologías digitales y la gestión eficiente de la información son componentes obligatorios para todo tipo de empresas y para todas las formas de comercio internacional. Le imprimen dinamismo al área de comercio de servicios, con mayor impacto, inclusive, que el comercio de bienes.

Impulsando la eficiencia, reduciendo costos y conectando a empresas y consumidores a nivel global, la digitalización ha facilitado la automatización de procesos, la optimización de cadenas de suministro y la expansión del comercio electrónico.

La segunda parte de esta cápsula analizará más a fondo esta relación de la computación con el comercio internacional, centrándonos en los análisis cuantitativos que realiza la Organización Mundial del Comercio, donde se analizan los efectos de tres tendencias:

- impactos de la robotización y la digitalización en la redistribución de tareas en la producción,

- aumento del uso de los servicios de TIC en el resto de la economía con su expansión en los procesos de producción y

- la caída de los costos del comercio como consecuencia de los cambios tecnológicos.

Lecturas consultadas:

- Negocios Internacionales: Historia, Importancia y Principales Relaciones Comerciales. Revista Raia Diplomática. 18 de noviembre, 2024. En: https://raiadiplomatica.info/2024/11/18/negocios-internacionales-historia-importancia-y-principales-relaciones-comerciales/#

- El impacto del avance tecnológico en el comercio internacional de México. Revista Debate Económico, Vol. 6 (2), No. 17, mayo-agosto, 2017, pp. 95-111. En: https://debateeconomico.org/wp-content/uploads/2023/02/17-05-avance-tecnologico.pdf

- Las enciclopedias: el caso particular de la Wikipedia. 2010, Researchgate.net. En: https://www.researchgate.net/publication/216292893_Cap_9_Las_enciclopedias_el_caso_particular_de_la_wikipedia

- The Nature of Information Technology related Industrial Attachment in Kenya. 2023, International Journal of Advanced Research in Computer and Communication Engineering. En: https://www.researchgate.net/publication/375355280_The_Nature_of_Information_Technology_related_Industrial_Attachment_in_Kenya

- Fundamentos de la Computación: Evolución de las Computadoras. 2010, Universidad Nacional Autónoma de México. En: https://gc.scalahed.com/recursos/files/r161r/w23942w/unidad_1/Evolucion_de_las_computadoras.pdf

- Desarrollo histórico de los dispositivos de computo. Conalep mexicano italiano. En: https://www.geocities.ws/gildardoaguilar/iisc1.pdf

- Las generaciones de ordenadores. ACTA (Autores científico-técnicos y académico). En: https://www.acta.es/medios/articulos/informatica_y_computacion/031035.pdf

- Impacto de las tecnologías digitales en la transformación del comercio internacional. Economía Internacional: cuadernos de información económica. En: https://www.iberglobal.com/files/2019-1/tecnologias_digitales_comercio_poncela.pdf

- Ley de Moore, nanotecnología y nanociencias: síntesis y modificación de nanopartículas mediante la implantación de iones. Revista Digital Universitaria UNAM. 10 de Julio 2005. Volumen 6 Número 7. En: https://www.revista.unam.mx/vol.6/num7/art65/jul_art65.pdf

- Entorno histórico y social de la aparición del microchip. Mayo 2014. Universidad Politécnica de Madrid. Escuela universitaria de ingeniería técnica de telecomunicación. En: https://oa.upm.es/34023/1/PFC_maria_gonzalez_mondaza.pdf

- Circuitos Electrónicos: Estado Actual, Innovaciones y Perspectivas Futuras. Marzo 2025. Researchgate.net. En: https://www.researchgate.net/publication/389696025_Circuitos_Electronicos_Estado_Actual_Innovaciones_y_Perspectivas_Futuras

- El futuro del comercio mundial: cómo las tecnologías digitales están transformando el comercio mundial. Organización Mundial del Comercio (OMC), 2018: Informe sobre el comercio mundial. En: https://www.wto.org/spanish/res_s/publications_s/world_trade_report18_s.pdf